Archivo Robots.txt: Qué es y cómo crearlo

Cuando lanzas una página web quieres o una tienda online necesitas que Google rastree la información, pero también tienes que darle una serie de directrices o instrucciones acerca de cómo debe interactuar con tu contenido. Por tanto, necesitas crear un archivo robots.txt.

Pero, ¿sabes qué es el archivo robots.txt y para qué sirve? ¿Necesitas ayuda para crear uno?

Si es así, sigue leyendo porque en este artículo te explico todo lo que necesitas sabes sobre el archivo robots.txt y cómo crear y subir el tuyo a Google.

¡Empecemos!

Tabla de contenidos:

¿Qué es el archivo robots.txt?

El archivo robots.txt es un archivo de texto, de ahí la extensión .txt, que sugiere a los buscadores como Google qué URLs de nuestro sitio debe rastrear y a qué partes de la página web no quieres que accedan los bots para rastrear el contenido.

Por decirlo de otra manera, el archivo robots.txt contiene un listado de URLs que no deseas que los buscadores como Google rastreen ni se muestren en los resultados de búsqueda.

Como sabes, por defecto, los robots o arañas de Google rastrean todo el contenido de tu página web (y cuando digo todo, es TODO), pero… ¿Qué ocurre si tienes un directorio que no deseas que Google lo indexe? Lo ideal, es incluirlo en este archivo. De esta manera, cuando un robot vaya a visitar tu sitio, antes comprobará el archivo robots.txt y sabrá qué instrucciones seguir.

No confundas noindex con robots.txt

¡Ojo! Que incluyas una determinada URL en el archivo robots.txt no quiere decir que Google no la vaya a indexar. Añadiendo la URL le estás sugiriendo a Google que no lo haga, después él hará lo que decida…. 😛

Si no quieres que una página web aparezca en Google, lo ideal es utilizar noindex o proteger la página con una contraseña.

¿Dónde está el archivo robots.txt?

Este archivo se encuentra en la raíz de tu página web. De hecho, tiene una ruta del tipo:

- https://tudominio.com/robots.txt

Reglas y formato del archivo robots.txt

Antes de ver los principales comandos que puedes incluir para crear el archivo robots.txt, es importante que tengas en cuenta algunos aspectos.

- El nombre del archivo debe llamarse sí o sí robots.txt. No puede tener otro nombre, en caso contrario no sería leído por los robots.

- Tu web únicamente puede tener un archivo robots.txt.

- El archivo robots.txt tiene que ubicarse en la raíz de la web y no en un directorio. Por tanto, https://tudominio.com/robots.txt sería válido, pero https://tudominio.com/blog/robots.txt no tiene validez.

- Sí puedes crear un archivo robots.txt para un subdominio y que aplique al mismo. Por ejemplo, https://shop.tudominio.com/robots.txt sería válido para el subdominio shop.tudominio.com.

Principales comandos de robots.txt

Para crear el archivo robots.txt, es necesario que conozcas algunos comandos básicos.

Comando User-agent

Este comando indica qué robot tiene que cumplir las directivas que componen en el archivo.

Si no quieres especificar qué robot debe cumplir las indicaciones, utiliza el siguiente comando:

User-agent: *

Para dar instrucciones específicas al robot de Google debes establecer:

User-agent: googlebot

En el caso del robot de Bing debes utilizar:

User-agent: googlebot

Comando Disallow

Este comando indica qué directorio o página de tu web no debe incluirse en los resultados de búsqueda.

En WordPress es muy habitual bloquear todas las URLs del panel de administración, para lo cual se utiliza:

Disallow: /wp-admin

O, en el caso del área de clientes, podrías utilizar:

Disallow: /area-de-clientes

Para indexar todo el contenido:

Disallow:

O, por el contrario, si no quieres que se rastree ninguna página del sitio:

Disallow: /

Comando Allow

Con este comando sugieres a los motores de búsqueda qué páginas o directorios sí quieres que sean rastreados.

Por defecto, ya se rastrea todo el contenido, por lo que solo necesitas este comando si quieres permitir el acceso a un contenido que has incluido dentro del comando Disallow. Por ejemplo:

Disallow: /noticias Allow: /noticias/actualidad

Comando Sitemap

El archivo robots.txt ayuda a los motores de búsqueda a indexar el contenido, así que, también es de mucha ayuda para ellos que en este archivo incluyas el sitemap de tu web.

Aunque es algo opcional, puedes añadir este comandoincluyendo la ruta en la que se encuentra el mapa o mapas de tu sitio:

Sitemap: https://tudominio.com/sitemap.xml

¿Todavía no tienes creado el sitemap en tu sitio? Entonces, te recomiendo que le eches un ojo a estos artículos:

Comando Crawl-delay

Este comando sirve para retrasar el tiempo de rastreo entre página y página para no afectar al rendimiento de tu sitio; especialmente útil para sitios muy grandes.

Crawl-delay: 1

Comodines $, * y #

Además de comandos, también existen una serie de comodines que serán útiles y necesarios para crear un archivo robots.txt:

- $: el símbolo del dólar indica el final de una URL.

- *: el asterisco representa «todos».

- #: la almohadilla sirve para incluir comentarios en el archivo.

Cómo crear un archivo robots.txt

Cuando instalas algunas aplicaciones como PrestaShop o Mautic, verás que ya tienen el archivo robots.txt preconfigurado en la raíz del dominio. En cambio, en otros gestores de contenido como WordPress hay que crearlo y subirlo al hosting.

¿Quieres ver cómo crear un archivo robots.txt? Vamos a ello.

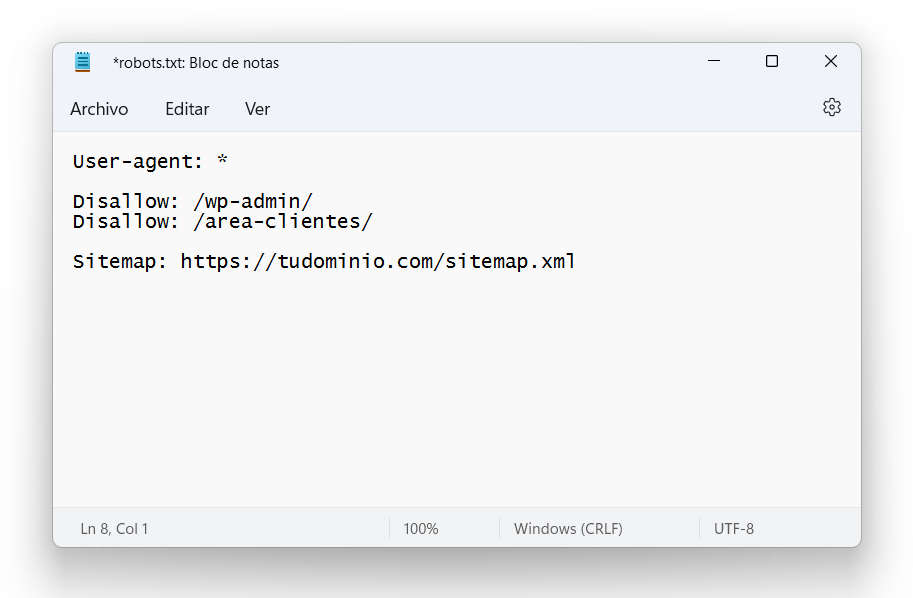

- Abre un editor de texto como, por ejemplo, el bloc de notas de Windows.

- Establece el user-agent. Puedes utilizar el comodín * para referirte a cualquier robot, o «googlebot» si las directrices son únicamnete para el robot de Google.

- Escribe las reglas que debe interpretar el user-agent. Utilizando los comandos que te mostré anteriormente, establece qué URL prefieres que Google no rastree.

- Añade la ruta del sitemap de tu sitio.

- Guarda el archivo con el nombre robots.txt y súbelo a la raíz de tu sitio. Esto puedes hacerlo mediante una conexión FTP o utilizando el Administrador de archivos de cPanel.

- Comprueba si es archivo robots.txt es legible o presenta algún error desde la herramienta Robots Testing Tools de Google Search Console

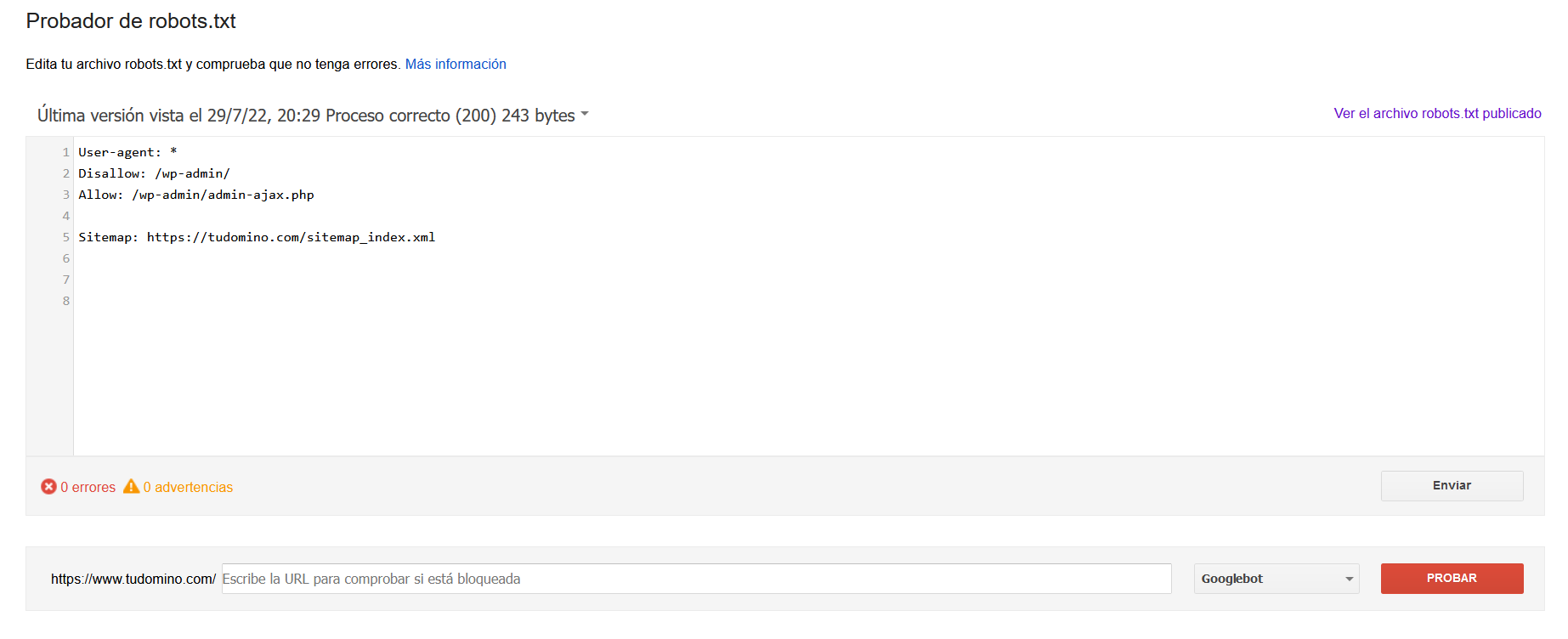

Aquí tienes un ejemplo de un archivo robots.txt sencillo:

Crear el archivo robots.txt en WordPress

Teniendo en cuenta que WordPress es el gestor de contenidos más utilizado para la creación de páginas web, es importante aclarar que, aunque este gestor de contenidos no lo crea por defecto al hacer la instalación, muchos plugins como Rank Math o Yoast SEO lo hacen por ti.

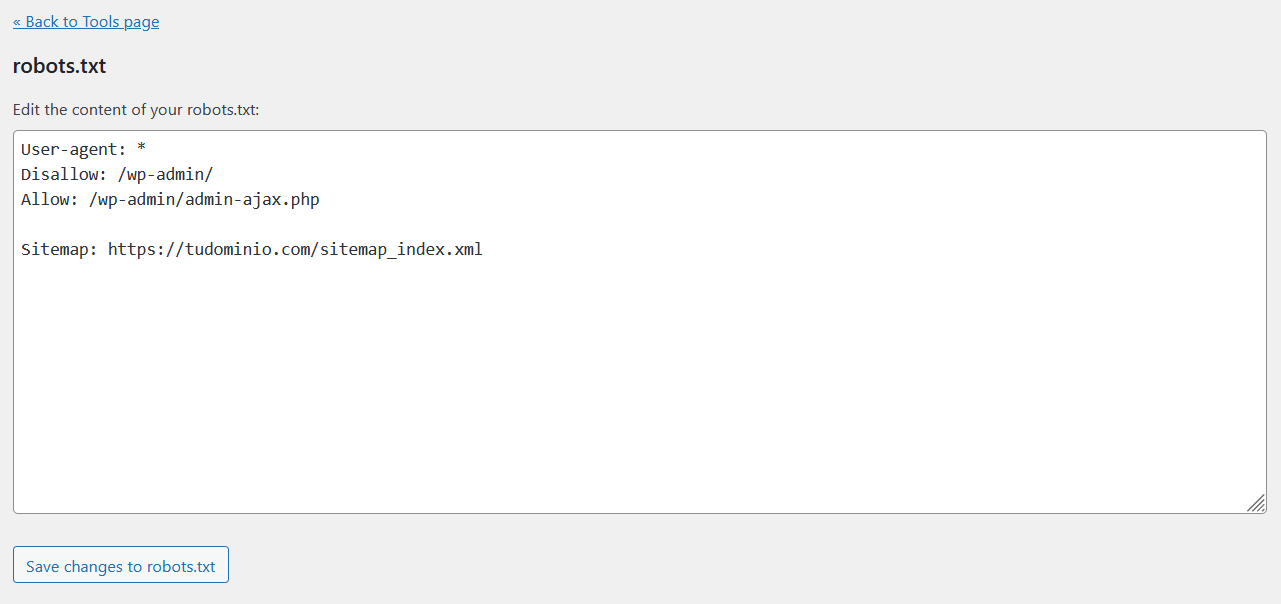

Crear el archivo robots.txt con Yoast SEO

Si tienes instalado Yoast SEO en tu aplicación, puedes crear y modificar este archivo en solo un par de clics. De hecho, es así de sencillo:

- Accede al panel de administración de WordPress y, en el menú lateral, haz clic en «Yoast SEO» para abrir la configuración del plugin.

- Abre la sección «Tools» o «Herramientas» y selecciona la segunda opción «File editor».

- Desde aquí verás que Yoast SEO te da la opción de crear el archivo robots.txt pulsando en el botón «Create robots.txt file».

- Por defecto, se genera un archivo robots.txt como este, pero puedes añadir nuevas directrices o eliminar las que no se ajusten a tu sitio.

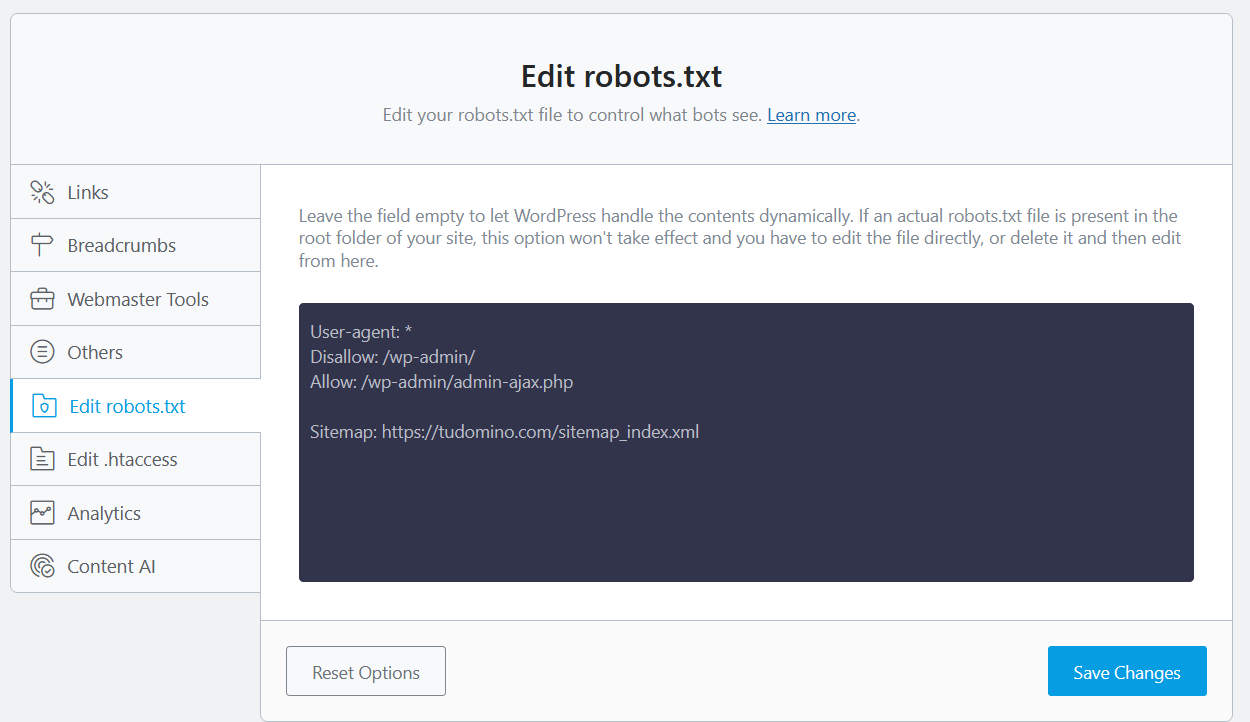

Crear el archivo robots.txt con Rank Math

Si utilizas este plugin para mejorar el posicionamiento de tu sitio, el proceso es igual de sencillo que con el plugin que acabamos de ver.

- Accede al panel de administración de tu web y, en el menú de WordPress, pulsa en Rank Math.

- Ve a «General Settings» (ajustes generales) y, a continuación, haz clic en «Edit robots.txt».

- Se abrirá una pestaña como esta en la que debes incluir las directrices que quieres que sigan los motores de búsqueda.

¡Importante! Aunque utilices alguno de estos plugins para crear el archivo robots.txt, no olvides enviarlo a Google a través de Search Console.

Enviar el archivo robots.txt a Google

Una vez crear el archivo robots.txt te preguntarás, ¿cómo hago para enviarlo a Google?

Desde la propia página de Google Developers nos dice que:

Una vez que hayas subido y probado tu archivo robots.txt, los rastreadores de Google buscarán y empezarán a usar el archivo robots.txt automáticamente. No tienes que hacer nada.

Actualizar el archivo robots.txt en Google

Si ya tienes el archivo creado y lo único que has hecho es actualizarlo añadiendo o eliminando directrices, entonces debes actualizar el que ya tienes subido.

En este caso, desde Google Developers nos indican que los rastreadores detectan los cambios hechos en el archivo robots.txt y actualizan la versión almacenada cada 24 horas.

Pero… ¿No puedes esperar tantas horas? ¿Necesitas que se actualice con mayor rapidez? Entonces haz lo siguiente:

- Abre el Probador de robots.txt de Search Console y haz clic en «Ver la versión subida» para comprobar qué archivo robots.txt se está utilizando.

- Haz clic en «Enviar» para avisar a Google de que tu archivo se ha actualizado.

Si quieres, puedes comprobar que esta actualización se realizó correctamente volviendo a la herramienta de Probador de robots.txt del punto 1.

En conclusión

Un archivo robots.txt permite indicarle a los buscadores como Google qué URLs de una página web debe rastrear y a qué partes no quieres que accedan los bots.

Este archivo que tiene que tener la extensión .txt y ubicado en la raíz del sitio indica a qué partes de la web no quieres que accedan los rastreadores de los motores de búsqueda.

Como hemos visto, la creación de este archivo puedes hacerla mediante el Bloc de notas, aunque si utilizas WordPress, casi cualquier plugin de SEO te permite hacerlo en solo un par de clics.

Ahora dime, ¿ya creaste tu robots.txt? ¿Tienes alguna duda? Déjame un comentario y te echo una mano 🙂 .

![Cómo actualizar Drupal [Guía paso a paso] Cómo actualizar Drupal [Guía paso a paso]](https://www.lucushost.com/blog/wp-content/uploads/2023/03/actualizar-drupal-220x159.png)

No hay comentarios