Tecnología y Sociedad

Las máquinas deben tener la misma responsabilidad legal sobre sus actos que las personas

Así lo asegura un grupo multidisciplinar de expertos que ha unido sus mentes para abordar el creciente problema de la carga legal sobre las decisiones tomadas por la inteligencia artificial. Afirman que la tecnología puede razonar por qué hace lo que hace sin tener que revelar cómo funciona

La inteligencia artificial (IA) está lista para desempeñar un papel importantísimo en la sociedad (ver Las cuatro olas de inteligencia artificial que caerán sobre la sociedad). En este contexto, es urgente abordar el problema de quién tiene la responsabilidad de sus acciones. Si dependemos de las máquinas para tomar decisiones cada vez más importantes, necesitaremos mecanismos para reparar los casos en los que sus resultados sean inaceptables o difíciles de comprender (ver La sociedad aprueba que un coche autónomo sacrifique al ocupante para salvar otra vida).

Pero conseguir que los sistemas de inteligencia artificial expliquen sus razonamientos no es nada fácil (ver El secreto más oscuro de la inteligencia artificial: ¿por qué hace lo que hace?). Uno de los problemas es que para obtener respuestas hace falta invertir una cantidad considerable de recursos para crear sistemas que se autoexpliquen, y después invertir aún más en el proceso del interrogatorio. Además, las explicaciones ofrecidas por los programas pueden revelar secretos comerciales, ya que sus desarrolladores estarían obligados a revelar su funcionamiento interno (ver Google advierte: el verdadero peligro de la IA no son los robots asesinos sino los algoritmos sesgados). Además, una ventaja de estos sistemas es que pueden dar sentido a datos complejos de formas que sean inaccesibles para los humanos. Por lo tanto, hacer que sus explicaciones sean comprensibles para los humanos podría requerir una reducción de su rendimiento.

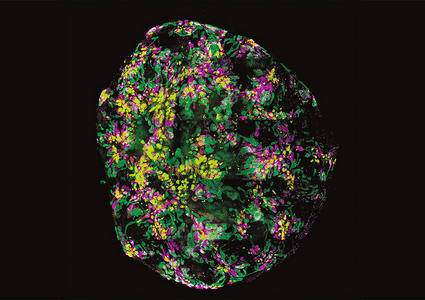

Foto: Los sistemas de explicación deben estar separados de los sistemas de inteligencia artificial, según el equipo de la Universidad de Harvard.

Entonces, ¿cómo podemos responsabilizar a la inteligencia artificial de sus decisiones sin limitar la innovación?

Hoy recibimos una especie de respuesta gracias al trabajo de los investigadores de la Universidad de Harvard (EEUU) Finale Doshi-Velez, Mason Kortz y varios compañeros. Este equipo de científicos informáticos, científicos cognitivos y académicos del derecho se han unido para explorar los problemas legales que plantean los sistemas de inteligencia artificial. Han abordado los problemas clave y sugerido posibles soluciones. El equipo asegura: "Juntos, somos expertos en la explicación de la ley, en la creación de sistemas de inteligencia artificial y en las capacidades y limitaciones del razonamiento humano".

Para empezar, el equipo ha definido el término "explicación". La investigación detalla: "Cuando hablamos de la explicación de una decisión, generalmente nos referimos a las razones o justificaciones que han dado lugar a ese resultado concreto, en lugar de una descripción del proceso de toma de decisiones en general".

Esta distinción es importante. El equipo de Doshi-Velez señala que es posible explicar cómo toma decisiones un sistema de inteligencia artificial, de la misma manera que se puede explicar cómo funciona la gravedad o cómo se hace una tarta. Se trata de establecer las reglas que sigue el sistema, sin referirse a ningún objeto que se caiga ni a ninguna tarta concreta.

Ese es el gran miedo de los actores de la industria, que quieren mantener en secreto el funcionamiento de sus sistemas para proteger su ventaja comercial.

Pero este tipo de transparencia total no siempre es necesaria. Explicar por qué un objeto cayó durante un accidente industrial, por ejemplo, no suele requerir una explicación sobre cómo funciona la gravedad. En lugar de eso, las explicaciones que suelen hacer falta se refieren a preguntas como estas: ¿Cuáles fueron los principales factores de una decisión? ¿Cambiar un determinado factor cambiaría la decisión? ¿Por qué dos casos similares condujeron a decisiones diferentes? Para responder estas preguntas no es necesario dar una explicación detallada de cómo funciona un sistema de inteligencia artificial.

Entonces, ¿cuándo se deben dar explicaciones? Básicamente, cuando el beneficio supera el coste. La investigación explica: "Hay tres condiciones que caracterizan las situaciones en las que la sociedad considera que un responsable de la toma de decisiones está obligado, desde el punto de vista moral, social o legal, a proporcionar una explicación".

Primero, el equipo explica que la decisión debe tener impacto en una persona que no sea la que toma las decisiones. Segundo, saber si la decisión fue tomada erróneamente debe generar valor. Y tercero, debe haber alguna razón para creer que se ha cometido (o que se cometerá) un error en el proceso de toma de decisiones.

Por ejemplo, los observadores pueden sospechar que una decisión ha sido influida por algún factor irrelevante, como un cirujano que se niegue a realizar una operación debido a la fase lunar. O pueden desconfiar de un sistema que ha tomado la misma decisión en dos conjuntos de circunstancias completamente diferentes. En ese caso, podrían sospechar que no ha tenido en cuenta un factor importante. Otra preocupación surge con decisiones que parecen beneficiar injustamente a un grupo, como cuando los directores corporativos toman decisiones que les benefician a costa de sus accionistas.

En otras palabras, debe existir una buena razón para creer que una decisión es incorrecta antes de exigir una explicación. Pero también puede haber otras razones para dar explicaciones, como intentar aumentar la confianza con los consumidores.

Entonces, los investigadores estudiaron situaciones legales concretas en las que se requieren explicaciones. Señalan que cualquier persona razonable es capaz de distinguir cuándo resulta moralmente justificable o socialmente deseable exigir una explicación. Los investigadores detallan: "Las leyes, por otro lado, están codificadas, y si bien uno podría discutir si una ley es correcta, al menos sabemos cuál es la ley".

La ley estadounidense requiere explicaciones en un amplio abanico de situaciones, y a distintos niveles de detalle. Por ejemplo, en casos de responsabilidad objetiva, de divorcio o de discriminación; para decisiones administrativas; y para jueces y jurados. Pero el nivel de detalle varía enormemente.

Todo eso tiene importantes implicaciones para los sistemas de inteligencia artificial. El equipo de Doshi-Vélez concluye que los sistemas de inteligencia artificial son capaces de dar explicaciones válidas a nivel legal. Esto se debe a que la explicación de una decisión puede hacerse independientemente de una descripción de su funcionamiento interno. Además, el equipo afirma que un sistema de explicación debe considerarse distinto del sistema de inteligencia artificial.

Estas conclusiones son importantes. No quieren decir que las explicaciones satisfactorias siempre vayan a resultar fáciles de generar. Por ejemplo, ¿cómo podemos demostrar que un sistema de seguridad que utiliza imágenes de una cara no discrimina en función del género? (ver Unámonos para evitar la discriminación de los algoritmos que nos gobiernan) Sólo sería posible usando una cara alternativa similar en todos los sentidos, excepto en el género, según el equipo.

Pero, por complicadas que sean, si las explicaciones de la IA son posibles, el equipo extrae una conclusión clara: "Recomendamos que, por el momento, los sistemas de inteligencia artificial pueden y deben estar sujetos a un nivel de explicación similar al de los humanos".

Pero es probable que nuestro uso y comprensión de la inteligencia artificial evolucione hacia formas que aún no entendemos (y quizás nunca lleguemos a comprender). Por esa razón, este enfoque deberá revisarse. El equipo concluye: "En el futuro, esperamos poder aplicar un estándar distinto a la inteligencia artificial". ¡Y qué lo digan!

Ref: arxiv.org/abs/1711.01134: Accountability of AI Under the Law: The Role of Explanation