アルゴリズムがグッジョブすぎるんだな。

うす暗い場所で撮影した画像をどうにか修正しようと、Photoshopで四苦八苦した経験があるという人は少なくないはず。

うまく微光撮影するには、おもにふたつのアプローチがあります。画像センサーのISO感度をあげるか、低速シャッター(ピンボケを防ぐためにはさらに三脚を使用する必要あり)を利用するかですね。これに加えて、機械学習のポテンシャルを証明してみせたのが、Intel(インテル)とイリノイ大学アーバナ・シャンペーン校の研究チームです。

研究では、それぞれ異なるセンサー技術を搭載した「Sony α7S II」と「Fujifilm X-T2 cameras」を使って撮影が行なわれました。

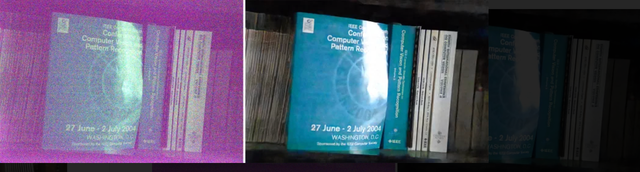

チームは、この画像のように暗いところで撮影された短時間露光画像(左)と、何が写っているかわかるように長時間露光撮影された画像(右)の5,094種類のデータセットを用意。ディープラーニング技術を活用して、アルゴリズムに「暗いところで撮影された写真が後処理でどのように修正されるべきか」を学習させました。

従来の画像処理ツールを使って明るさを調整したもの(左)と、ディープラーニングアルゴリズムで修正したもの(右)が以下の画像。ふたつとも同じ画像を用いて処理されたとのことですが、研究段階にしてこのクオリティ。アルゴリズムによる画像修正の鮮明度には脱帽です…。

もちろん、先述の低速シャッターや三脚を利用する方法のほうがよっぽど上手に写真を撮れるはずではあるんですけどね。

間接照明のきいたカフェ、コンサート会場、野生動物の撮影などなど…今回のアルゴリズム技術が活用できそうなフォトスポットならばちょっと想像しただけでも頭に浮かんでくるのですが、三脚を立ててまで撮影するほどの場所ってどこかしらん(なかなか思いつかない)。

身近なところでいえば、このアルゴリズムがスマホのカメラアプリに採用されたら便利であることはもう言わずもがなですよね。少なくとも、スマホに内蔵された小さなセンサーが一眼レフと同等の性能を発揮する日が来るまでは、こういう機能に期待を寄せたくなります。

もしかすると、ある日ソフトウェアをアップデートしたら何気なく導入されていた…という展開だって、今後なきにしもあらず。

Image: University of Illinois Urbana–Champaign

Source: Learning to See in the Dark via BoingBoing

Andrew Liszewski - Gizmodo US[原文]

(Rina Fukazu)