Heterogene Infrastruktur im Netzwerk einsetzen Mit openQRM Clouds verwalten

Unternehmen, die parallel auf lokale Serverdienste und Clouddienste setzen sowie auf Services aus der Public Cloud, benötigen zentrale Verwaltungslösungen, die alle vorhandenen Serverdienste ansteuern können.

Anbieter zum Thema

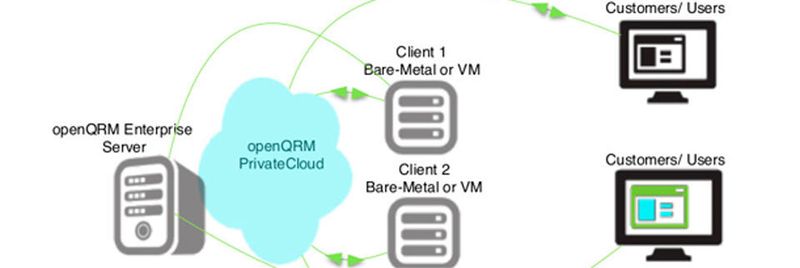

Cloud-Managementsysteme wie openQRM bieten eine webbasierte Oberfläche an, mit der sich alle angebundenen Server- und Clouddienste zentral verwalten lassen. Im Fokus der Umgebung steht die Verwaltung von verschiedenen Clouddiensten unterschiedlicher Hersteller. Dabei spielt es keine Rolle ob es dabei um private, öffentliche oder hybride Clouds handelt.

openQRM kann lokal betriebene Clouds verwalten und zentral alle notwendigen Verwaltungsaufgaben steuern, die notwendig sind. Unternehmen, die mehrere interne Lösungen parallel einsetzen, erhalten so eine zentrale Verwaltungsoberfläche. Es ist also nicht gezwungenermaßen notwendig, dass auch öffentliche (public) Clouds angebunden werden, um einen Einsatz von openQRM zu rechtfertigen. Das ist zwar jederzeit problemlos möglich, aber keine Voraussetzung für den lohnenswerten Einsatz von openQRM.

openQRM baut auf Linux auf, vor allem auf Ubuntu oder Debian. Aber auch Red Hat Linux, SUSE oder CentOS können als Grundlage für openQRM verwendet werden. In einer produktiven Umgebung sollte der Einsatz auf physischen Servern geplant werden, damit genügend Leistung für die Bereitstellung der Umgebung zur Verfügung steht. In AWS steht openQRM auch als virtueller Server bereit. Auf Youtube gibt es dazu ein Video, in dem die Orchestrierungsmöglichkeiten von Amazon EC2 mit openQRM näher erläutert werden. Mit der Lösung kann die private Cloud genauso verwaltet werden, wie eine hybride Infrastruktur mit AWS-Ressourcen. Im Fokus steht hier aber vor allem der Test und der Aufbau einer Infrastruktur, zusammen mit AWS.

openQRM lässt sich mit Plug-Ins erweitern

openQRM kümmert sich nach der Einrichtung um das Provisioning genauso wie um die Verfügbarkeit der Serverworkloads und VMs, quer über die angebundenen Cloudlösungen. Einer der Vorteile von openQRM liegt darin, dass die Lösung auch Plug-Ins unterstützt. Dadurch lassen sich die Funktionen der Umgebung erweitern und verbessern.

Im Fokus von openQRM liegt es nicht, alle Verwaltungsmöglichkeiten für eine wie auch immer geartete Cloudumgebung zur Verfügung zu stellen. Die Entwickler sehen openQRM eher als Framework, das in der Lage ist bekannte Verwaltungsfunktionen von Drittanbietern zusammenzuführen und einer zentralen Oberfläche zu vereinen.

Als Beispiel verfügt openQRM über keine eigene Überwachungsfunktion, kann aber problemlos Nagios, Zabbix und andere bekannte Verwaltungstools integrieren. Mit etwas Einarbeitung können Administratoren und Entwickler die Umgebung sogar selbst ausbauen. Insgesamt lassen sich bereits nach der Installation weit über 50 Plugins anbinden.

Bestandteile von openQRM - Cloud, Virtualisierung, Container

openQRM besteht generell aus verschiedenen Komponenten. Die Basis der Umgebung stellt die Umgebung selbst bereit und verfügt über grundlegende Komponenten. Hier ist auch die API der Plug-Ins positioniert, die mit den anderen Lösungen kommuniziert. Bereits nach der Installation lassen sich problemlos VMware vSphere, Citrix XenServer, KVM und OpenVZ anbinden, das gilt auch für LXC. Neben Cloudlösungen und virtuellen Umgebungen können also auch Container-Infrastrukturen integriert werden. Daher kann auch eine Docker-Umgebung mit openQRM verwaltet werden.

Zusätzlich kann openQRM auch verschiedene Storage-Umgebungen ansprechen, um diese an die zentrale Verwaltungslösung anzubinden. Neben iSCSI, NFS oder LVM, unterstützt openQRM auch AoE. Damit können die meisten maßgeblichen Storagelösungen an openQRM angebunden werden. Betreiben Unternehmen ein Self-Service-Portal, können sie also auch die Zuweisung des Speichers automatisieren, ohne dass Administratoren komplizierte Freigaben oder Regeln erstellen müssen. Sobald die Infrastruktur einmal eingerichtet ist, können die einzelnen Endbenutzer die Ressourcen anfragen, die sie benötigen. Den Rest übernimmt openQRM auf Basis der hinterlegten und angebundenen Ressourcen.

Virtuelle Umgebungen, Clouds und physische Netzwerke anbinden

Auch DNS, DHCP oder andere Infrastrukturdienste können angebunden und zentral für die Cloudlösung zur Verfügung gestellt werden, genauso wie Wake-On-LAN oder das Booten über das Netzwerk mit PXE. Dadurch kann openQRM also nicht nur virtuelle Umgebungen verwalten, es ist auch möglich, physische Server bereitzustellen, auf Wunsch auch mit Windows.

Die automatisierte Installation des Betriebssystems erfolgt dann auf Basis eines Images, das Administratoren einmal vorbereiten und dann in openQRM hinterlegen. Auch hier zeigt sich der Vorteil der offenen Struktur von openQRM. Über Plug-Ins lassen sich Systeme wie Puppet oder Ansible integrieren, um zusammen mit openQRM Systeme automatisiert bereitstellen zu können. Für Windows-Images unterstützt openQRM auch Sysprep, um Abbilder selbst zu erstellen. Hyper-V kann zwar ebenfalls angebunden werden, allerdings ist openQRM klar auf Linux-Virtualisierer ausgelegt. Wer eine Verwaltungslösung für Hyper-V sucht, ist mit openQRM eher nicht zufrieden.

Über einen Connector lassen sich öffentliche Cloudlösungen anbinden. Dazu gehört AWS und Microsoft Azure genauso wie Opensource-Lösungen auf Basis von Eucalyptus oder OpenStack. Zur Anbindung kann sich openQRM der APIs bedienen, die von den Herstellern der jeweiligen Cloudlösung zur Verwaltung von Zusatztools angeboten werden. Um die Cloudlösungen mit openQRM zu verwalten, trägt der Administrator die dazugehörigen Anmeldedaten im Server ein.

Delegierung von Rechten

Der Vorteil von Lösungen wie openQRM besteht auch darin, dass sich Rechte für die Umgebung sehr flexibel und zentral steuern lassen. Administratoren müssen nicht dediziert in jeder angebundenen Virtualisierungs- oder Cloudumgebung Rechte anpassen, sondern können innerhalb von openQRM eine zentrale Rechtestruktur vorgeben. Das Rechtemodell ermöglicht auch die Zuteilung von Ressourcen über ein Self-Service-Portal. Unternehmen können also Abteilungen die Möglichkeit geben selbst virtuelle Server anzufordern und bereitzustellen. Die Bereitstellung wird direkt über openQRM mit dem jeweils konfigurierten Cloudsystem zur Verfügung gestellt.

Die Benutzerkonten werden entweder intern in openQRM gespeichert, oder über ein LDAP-System angebunden. Neben dem Zuteilen von Benutzerrechten unterstützt openQRM natürlich auch ein Rollenmodell. Das vereinfacht die Erstellung von gruppierten Rechten und deren Zuteilung an die verschiedenen Benutzer.

Lifecycle-Management inklusive

Durch seine zahlreichen Funktionen bietet openQRM also echtes Lifecycle-Management für eine Umgebung. Neben der Anforderung und Bereitstellung von Ressourcen, können Administratoren und Endbenutzer VMs auch steuern. Dazu gehört auch das Ein- und Ausschalten von VMs unabhängig von der virtuellen Infrastruktur in der diese betrieben wird.

Es lassen sich sogar Regeln hinterlegen, mit denen openQRM aktuell nicht benötigte Server ausschalten kann, um Energie zu sparen. Wird ein Server wieder benötigen, startet die Umgebung diesen und stellt seine Einsatzbereitschaft sicher.

Hochverfügbarkeit verwalten

openQRM kann nicht nur selbst hochverfügbar betrieben werden, sondern kann auch die Hochverfügbarkeit der angebundenen Ressourcen sicherstellen. Um sich selbst hochverfügbar zu betreiben, kann openQRM auf die Hochverfügbarkeitsfunktionen von Linux zurückgreifen, zum Beispiel Pacemaker oder Corosync.

Fällt ein bestimmter Hypervisor aus, erkennt das openQRM und kann automatisierte Abläufe für die Hochverfügbarkeit starten. Hierbei können zum Beispiel VMs automatisiert auf anderen Hypervisoren gestartet werden. Generell kann openQRM einen ausgefallenen virtuellen Server sogar auf einem physischen Server bereitstellen.

Auch auf die virtuellen Serveranwendungen innerhalb der virtuellen Server der Umgebung kann openQRM einwirken. Mit entsprechenden Regeln können Administratoren sicherstellen, dass die Verfügbarkeit von virtuellen Anwendungen gegeben ist und durch openQRM überwacht wird. Auch hier kann openQRM auf Pacemaker setzen. Über eine grafische Oberfläche lässt sich die Hochverfügbarkeit der angebundenen VMs steuern. Dazu bindet sich openQRM direkt in das Linux Cluster Management ein.

Neben der Opensource-Community-Edition, steht openQRM auch als kostenpflichtige Variante zur Verfügung. Unternehmen können hier entweder die Enterprise-Edition erwerben, die kleinere Private Cloud Edition, oder einzelne Module. Die Entwickler stellen auch auch eine Testversion zur Verfügung, mit der sich die ganze Lösung 30 Tage lang testen lässt.

(ID:44963862)

:quality(80)/p7i.vogel.de/wcms/d1/4f/d14f0c11fbf6e5d56fdfeb16437e7048/0115479470.jpeg)

:quality(80)/p7i.vogel.de/wcms/b8/61/b8615878dfcb9b7383269a429384a593/0115304715.jpeg)

:quality(80)/p7i.vogel.de/wcms/3d/98/3d98b69e471f34ee67173e2b19150983/0115412594.jpeg)

:quality(80)/p7i.vogel.de/wcms/8a/b3/8ab361c0aa8f6268832881464f23a529/0117615533.jpeg)

:quality(80)/p7i.vogel.de/wcms/89/0e/890e6d131e5e270b3929be52654aac59/0117400623.jpeg)

:quality(80)/p7i.vogel.de/wcms/5b/e2/5be2eca51412f3d78b0247ee6583b598/0117266067.jpeg)

:quality(80)/p7i.vogel.de/wcms/c7/52/c752708829836bd8068f1f5a3662b706/0117959669.jpeg)

:quality(80)/p7i.vogel.de/wcms/b7/b3/b7b39f210afdbde0b94af77adf75e1cc/0116951275.jpeg)

:quality(80)/p7i.vogel.de/wcms/8b/30/8b309f39c2fb3404a47453a73580adb4/0117705366.jpeg)

:quality(80)/p7i.vogel.de/wcms/ee/27/ee27236a1edae9b9c07631ddf61392fc/0117218858.jpeg)

:quality(80)/p7i.vogel.de/wcms/17/b7/17b7b5c26b88818bcc7969589e912496/0117613806.jpeg)

:quality(80)/p7i.vogel.de/wcms/1c/1f/1c1fed19a1e90eb638ae9f8ea451d8fa/0117888893.jpeg)

:quality(80)/p7i.vogel.de/wcms/83/a3/83a32a57c7d2f700adb7e7169ee669cb/0117143187.jpeg)

:quality(80)/p7i.vogel.de/wcms/a8/67/a867d7d6bb999b389be521391938228e/0117612543.jpeg)

:quality(80)/p7i.vogel.de/wcms/ec/e8/ece8b409d6a81bebed4f2371a42b054e/0117932238.jpeg)

:quality(80)/p7i.vogel.de/wcms/40/00/40003b140b3fd49c47ff032dba637a82/0117824223.jpeg)

:quality(80)/p7i.vogel.de/wcms/32/32/32324821b5a4e8e69c872726c13d828a/0117610599.jpeg)

:quality(80)/p7i.vogel.de/wcms/46/4f/464f9874393542fda430ec285f3c0c65/0117931419.jpeg)

:quality(80)/p7i.vogel.de/wcms/02/e0/02e02be7aae78d444104e3424d8b95fc/0117904124.jpeg)

:quality(80)/p7i.vogel.de/wcms/71/ab/71ab1e5c80cb2e89643ce54481ac4f41/0117883495.jpeg)

:quality(80)/p7i.vogel.de/wcms/1d/5f/1d5ff604e768dc07af9d7a5e934aac13/0117587541.jpeg)

:quality(80)/p7i.vogel.de/wcms/30/3d/303dee95ed8a8c2ffe1df16ad1b6f371/0117576672.jpeg)

:quality(80)/p7i.vogel.de/wcms/85/a7/85a7e47314bd1ff01cd0ef3dab86d088/0117440139.jpeg)

:quality(80)/p7i.vogel.de/wcms/a3/22/a322cb08846922fbb3ff2ff456088565/0117584477.jpeg)

:quality(80)/p7i.vogel.de/wcms/bf/7e/bf7ecbbfd3a815ad7160b3fcfc4eb847/0117775397.jpeg)

:quality(80)/p7i.vogel.de/wcms/09/73/097302aa1b7e01683424de334a8a56a8/0117567518.jpeg)

:quality(80)/p7i.vogel.de/wcms/4a/f9/4af97680066d2bdf0f21aef50ff77703/0117543337.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/60/50/60506ac0f0156/cohesity-2-color-black-logo.png)

:fill(fff,0)/p7i.vogel.de/companies/64/f1/64f18cf620acb/stackit-logo.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/66/05/66054c7f87e44/emma-logo.png)

:quality(80)/p7i.vogel.de/wcms/49/00/49003421cc987c799ddf3dd3fcf1cf7b/0112387357.jpeg)

:quality(80)/p7i.vogel.de/wcms/18/1b/181bc2876cd2fdb29c08bcd6e75bf587/0111271200.jpeg)