Websites in Not: Wie KMU mangels Grundlagenwissen weiterhin viel SEO-Potenzial verschenken

Die gute Nachricht zuerst: Es herrscht Chancengleichheit, denn vor dem folgenden Problem stehen KMU, Selbstständige und große Unternehmen gleichermaßen – ihre jeweiligen Unternehmenswebsites müssen einen perfekten Spagat beherrschen. Zum einen sollen sie die in der Content-Strategie definierten Zielgruppen erreichen und im Idealfall vom Produkt oder der dargebotenen Dienstleistung überzeugen. Zum anderen müssen sie in Suchmaschinen zu relevanten Keywords ranken und durch professionelle Content-Distribution an die Zielgruppe gebracht werden. Tun sie das nicht, können die Inhalte noch so gut sein – es rezipiert sie kaum jemand. Also müssen alle Unternehmen die Suchmaschinen ebenso beeindrucken wie die menschlichen Leser. Ein Spagat eben …

Und jetzt die schlechte Nachricht: Dabei werden SEO-Potenziale verschenkt, dass die Heide wackelt und der Weihnachtsmann neidisch wird. Wer das sagt? Zwei Studien – eine aktuelle deutsche sowie eine internationale, die wir im Folgenden vorstellen. Auf Basis der Ergebnisse zeigen wir, wie KMU und Selbständige SEO-Potenziale weitaus besser ausschöpfen (können).

Bitkom: 87 Prozent der Unternehmen erreichen Kunden via Website – nur 40 Prozent setzen auf Suchmaschinenoptimierung

Aber noch einmal zurück auf Start. Der Branchenverband Bitkom (PDF) fragte kürzlich Unternehmen ab 20 Mitarbeitern, welche digitalen Touchpoints sie nutzen, um Kunden zu erreichen. Auf Platz eins landeten – natürlich (!) – Unternehmenswebsites und -blogs. 87 Prozent der Befragten gaben sie als Berührungspunkt an. Auf den Plätzen folgen Newsletter und Mailings sowie Webshops. Suchmaschinenoptimierung (SEO) nannten hingegen nur 40 Prozent der Studienteilnehmer.

Und ja, es waren Mehrfachnennungen möglich.

SEO-Studie von 3.513 Internetpräsenzen: „Die Websites deutscher KMU sind nicht auf dem aktuellen Stand.“

Die aktuelle und mittlerweile dritte SEO-Studie „mIndex 2017“ der Kölner Internetagentur mindshape von SEO-Experte Sebastian Erlhofer kommt ebenfalls zu einem ernüchternden Ergebnis: „Websites deutscher KMU sind nicht auf dem aktuellen Stand.“

Weiter heißt es in dem Ergebnis-PDF:

Der Grad der Suchmaschinenoptimierung deutscher Unternehmenswebsites steigt 2017 zwar langsam weiter an, dennoch lassen sich noch diverse Defizite finden. Vor allem in grundlegenden technischen Bereichen, wie Mobiltauglichkeit, Verschlüsselung und Ladezeit bleiben die deutschen KMU weit hinter den aktuellen Anforderungen der Nutzer und Suchmaschinen zurück.

Mit anderen Worten: Die Unternehmen verschenken Potenzial.

Im Herbst dieses Jahres untersuchten die Studienmacher automatisiert 3.513 Websites (und von ihnen jeweils fünf bis neun Unterseiten) deutscher Unternehmen aus 15 Branchen in 16 Bundesländern. Damit ist die Studie zwar nicht komplett statistisch repräsentativ, aber aufgrund ihrer Datenmenge aussagekräftig.

Kurioses Teilergebnis: Ein Großteil der untersuchten Domains weist einen Sichtbarkeitsindex in dem verwendeten SEO-Tool von 0,0 (in Worten: null Komma null) auf. Der oben beschriebene Spagat gleicht hier somit eher einem fulminanten Hüftschaden.

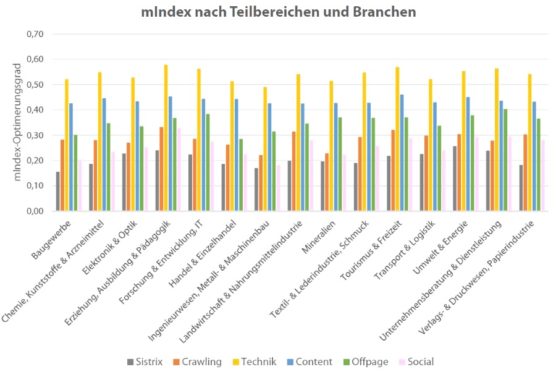

Um die Einzelergebnisse vergleichbar zu machen, entwickelten die Studienmacher einen Index. Der setzt sich aus 34 verschiedenen Faktoren zusammen, nennt sich „mIndex“ und wird für die untersuchten 15 Branchen ausgewiesen. Demnach sammelten alle Wirtschaftszweige im Bereich Technik die meisten Punkte, es folgen Content und Offpage.

Hier die Gesamtergebnisse der Untersuchung, unterteilt nach Teilbereichen und Branchen:

Quelle: mIndex SEO-Studie 2017

Quelle: mIndex SEO-Studie 2017

Ergebnisse zur Crawlability: Warum sollten wir es den Suchmaschinen einfach machen, unsere Website zu finden und Inhalte zu verstehen, wenn es auch kompliziert geht?

Suchmaschinen wie Google nutzen Webcrawler, um neue Websites zu finden und auf den bereits im Index befindlichen Seiten nach aktuellen bzw. aktualisierten Informationen und Links zu suchen. Website-Betreiber können die Crawlability beeinflussen und damit maßgeblich zum Rankingerfolg beitragen. Zentral sind dafür: die robots.txt sowie die XML-Sitemap.

Während die robots.txt – vereinfacht ausgedrückt – die Crawler über die eigene Website steuert, liefert die XML-Sitemap im Idealfall eine Übersicht der verfügbaren Inhalte und bietet der Suchmaschine somit eine strukturelle Grundlage, um den Aufbau der Website besser zu verstehen.

- Im Vergleich zu den Vorjahren ist der Anteil der von mindshape untersuchten Websites mit einer robots.txt um vier Prozent angestiegen. 62 Prozent nutzen 2017 eine robots.txt zur Crawler-Steuerung.

- Mehr als ein Drittel verzichtet auf dieses grundlegende Element.

- Beinahe aberwitzig mutet das Ergebnis zur XML-Sitemap an: Nur ein Viertel der Unternehmen nennt sie in der robots.txt. Davon weisen jedoch mehr als 80 Prozent überhaupt keinen Inhalt auf.

Deshalb gilt: Um die korrekte Indexierung der Website zu gewährleisten, muss das robots-Metadaten-Element nicht nur vorhanden, sondern auch einwandfrei ausgefüllt sein. Dasselbe gilt für die XML-Sitemap. Insbesondere bei Websites, die (wie Webshops) dynamische HTML-Seiten haben, deren Inhalte sich häufig ändern.

Ladezeit, Mobiloptimierung & Sicherheit: Käffchen? Plätzchen? Wir brauchen noch einen kleinen Augenblick!

Sowohl die Crawler der Suchmaschinen als auch die vom Content-Shock geplagten Internetnutzer, die nach relevanten Informationen suchen, sich für einen Newsletter eintragen oder etwas bestellen möchten, warten nicht gerne. Deshalb ist die Ladezeit einer Seite nicht nur ein direkter Rankingfaktor, sondern auch wichtig für die Usability und damit die Nutzersignale.

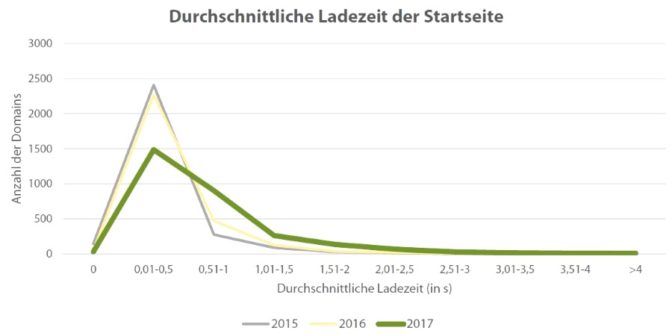

- Die durchschnittliche Ladezeit der Startseite aller in der „mIndex“-Studie untersuchten Seiten beträgt 0,7 Sekunden.

- Im Vergleich zum Vorjahr ist die Ladezeit um fast das Doppelte (!) angestiegen.

- Die Anzahl der Seiten mit Ladezeiten von bis zu drei Sekunden hat deutlich zugenommen.

- Der SEO-Tool-Anbieter SEMrush kommt in einer internationalen Analyse von 100.000 Websites zu einem ähnlichen Ergebnis: Demnach haben 23,16 Prozent der untersuchten Websites zu lange Ladezeiten.

Quelle: mIndex SEO-Studie 2017

Quelle: mIndex SEO-Studie 2017

Unser Rat: Schnell, schneller, SEO. Mit welchen konkreten Maßnahmen Website-Betreiber beim Laden der Seiten aufs Gas treten können, haben die Experten des SEO-Tools Ryte in diesem lesenswerten Beitrag zusammengetragen.

Seit Google im Oktober 2016 seinen Mobile First Index ankündigte, steht fest, dass die Responsivität von Websiteinhalten zukünftig zur Grundlage des Rankings wird. Seiten, die nicht auf die Darstellung auf mobilen Endgeräten optimiert sind, dürften dann Rankingverluste erwarten. Die Kölner Agentur mindshape untersuchte deshalb auch, wie viele Domains aktuell auf Mobiloptimierung setzen:

- Dabei gibt es einen Zuwachs von 13 Prozent.

- 2017 nutzen rund 41 Prozent aller untersuchten Domains Responsive Webdesign.

- Das bedeutet jedoch auch: 59 Prozent verzichten bisher darauf.

Deshalb gilt: Vor allem Websites, die hohe Zugriffsraten von mobilen Endgeräten haben, sollten auch zukünftig das volle Ranking-Potenzial ausnutzen. Diesbezüglich äußert sich Google außergewöhnlich deutlich:

Responsive Webdesign ist der von Google empfohlene Ansatz.

Weiteres Ergebnis der Untersuchung von KMU-Websites: 75 Prozent nutzen noch nicht das HTTPS-Protokoll, um Daten im Internet zu übertragen. Neben einem wichtigen Vertrauenssignal gegenüber den Nutzern ist der Sicherheitsaspekt auch wieder relevant für Google. Die Suchmaschine wertet HTTPS als Qualitätsfaktor. Viele Browser kennzeichnen Seiten ohne HTTPS-Protokoll mittlerweile sogar als „nicht sicher“.

Was es bei der Implementierung von HTTPS zu beachten gilt, zeigt SEMrush.

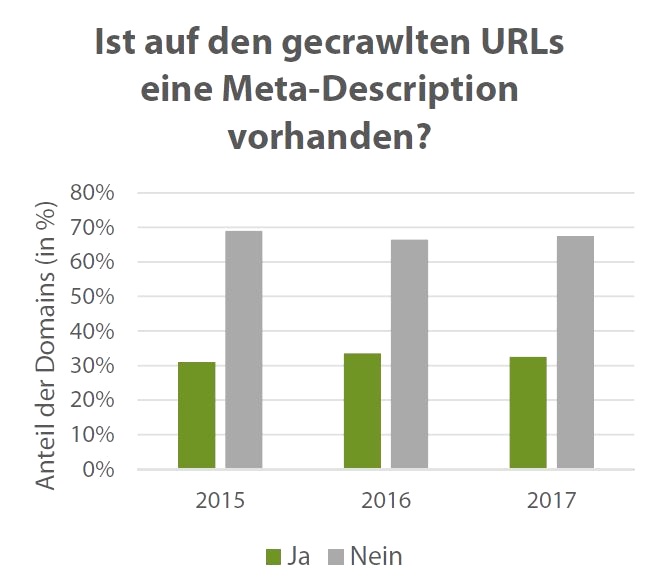

Meta-Angaben: Rund 60 Prozent der untersuchten URLs liefern keine Meta-Description für das Snippet mit

Selbst SEO-ABC-Schützen wissen: Meta-Angaben wie der Title-Tag und die Meta-Description sind wichtige Elemente der OnPage-Optimierung. Der Title-Tag gibt das Thema einer URL an und sollte somit auch das jeweils wichtigste Keyword liefern. Gemeinsam mit der Meta-Description bildet er das auf den Suchergebnisseiten zu sehende Snippet.

- Es gibt zwar im Vergleich zum Vorjahr weniger URLs mit Title-Tag, insgesamt liegt der Wert aber mit 80 Prozent in einem „ordentlichen“ Bereich.

- Allerdings verfügen nur 32,5 Prozent der analysierten URLs über eine Meta-Description.

- Dieses Ergebnis wird von der ebenfalls bereits zitierten SEMrush-Studie gestützt. Sie kommt auf 63,28 Prozent fehlende Meta-Descriptions.

Quelle: mIndex SEO-Studie 2017

Warum ist das wichtig und wie macht man es besser? Um es mal ganz simpel auszudrücken: Title-Tag und Meta-Description bieten die Möglichkeit, direkt mit der Suchmaschine zu kommunizieren und ihr mitzuteilen, um was es auf den einzelnen Seiten ganz konkret geht. Insbesondere der Title-Tag ist diesbezüglich relevant. Die Meta-Description hingegen ist eher in Bezug auf die User der Suchmaschine interessant, da Webseitenbetreiber hier nicht nur vergleichsweise ausführlich die Seiteninhalte vorstellen, sondern zum Beispiel auch mit einem animierenden Call-to-Action arbeiten können.

Und dieses Thema wird gerade auch wieder für die Webmaster interessant, die diese Meta-Angaben in der Vergangenheit gewissenhaft ausgefüllt haben. Denn Google liefert in den Suchergebnissen mittlerweile zum Teil längere Descriptions aus.

Linkfarmen, ick hör euch trapsen! Die Anzahl der Backlinks ist stark zurückgegangen

Interessante Ergebnisse liefert die Studie von mindshape auch bezüglich der Domainpopularität, also der Anzahl unterschiedlicher verlinkender Domains. Im Offpage-Bereich gilt beim Thema Backlinks spätestens seit Googles Pinguin-Update 2016 „Qualität vor Quantität“. Es kommt also nicht darauf an, so viele Verlinkungen auf die Unternehmenspräsenz zu leiten, wie nur möglich, sondern Backlinks aus qualitativ hochwertigen und thematisch zum eigenen Angebot passenden Seiten zu „verdienen“.

Hier die Ergebnisse:

- Die Zahl der verlinkenden Domains liegt durchschnittlich bei 129 – und ist teilweise um 75 Prozent zurückgegangen.

- Die Domain-Popularität ist damit im Schnitt um 48 Links zum Vorjahr gesunken.

Die Empfehlungen für diesen Bereich sollten damit klar sein: Backlinks gilt es, durch Qualitätscontent zu erarbeiten und nicht durch dicke Geldbörsen zu kaufen. Die Ergebnisse deuten darauf hin, dass diese Erkenntnisse teilweise bereits in den Unternehmen angekommen sind.

Wie man qualitativ hochwertige Inhalte plant, produziert und distribuiert, haben wir hier auf Zielbar schon mehrfach beschrieben. In unserem Online-Magazin gibt es Praxisanleitungen, Hintergrund und Meinung dazu.

Eine Website ist niemals fertig!

SEO ist ein dynamischer Prozess, und genauso wie für die Inhalte einer Webpräsenz gilt für die Suchmaschinenoptimierung: Eine Website ist niemals fertig. Denn Googles Suchalgorithmus verändert sich ebenso schnell wie die Ansprüche der Zielgruppen wachsen.

Das Webangebot muss daher kontinuierlich bezüglich seiner Performance gegenüber Suchmaschinen und menschlichen Usern analysiert und gegebenenfalls optimiert werden. Studien – wie die hier vorgestellten – zeigen, dass es dafür genug Potenzial gibt.

Aber – und das ist das letzte Ergebnis – selbst hier gibt es noch Nachholbedarf: Der Anteil der Unternehmen, die eine Tracking- und Analysesoftware nutzen, um das Verhalten der Besucher zu erfassen und die Website auf dieser Basis anzupassen, liegt bei unter 50 Prozent. Das deckt sich wiederum mit einem Bitkom-Ergebnis, nachdem immerhin 32 Prozent der befragten Unternehmen planen, solche Software zukünftig zu nutzen.

Zusammenfassend halten wir also fest: Wer sich von Mitbewerbern abheben möchte, sollte nicht allein auf Content-Qualität, sondern auch auf die Sichtbarkeit in Suchmaschinen setzen. Das Gute daran: Qualitativ hochwertiger Content, der gleichermaßen auf die Bedürfnisse von Mensch und Suchmaschine abgestimmt ist, stärkt die Sichtbarkeit.

Vernachlässigen Unternehmen diesen Aspekt, spielen sie Verstecken mit ihrer Zielgruppe.

Artikelbild: Martin Mummel/GRVTY

(Leider) Die reine Wahrheit. Tagesgeschäft.

Das ist wirklich erschreckend. Gerade wenn man bedenkt, dass die gängigen CMS und Shop Systeme viele der genannten Probleme durch einfache kostenlose Plugins bereits lösen könnten.

Stimmt, das Ergebnis ist nichts für schwache Nerven. ;)

Danke für den Kommentar!

Gerade für kleine Unternehmen ist die SEO Arbeit so wichtig und im Grunde auch kein Hexenwerk. Oft sind die Ressourcen jedoch einfach nicht vorhanden und das Unternehmen hat keine ausreichenden Kenntnisse und nicht die Zeit. Dabei würde es sich für die KMU langfristig auszahlen, die Verantwortung für die Suchmaschinenoptimierung abzugeben und in professionelle Hände zu geben.