Est-il possible de tromper une IA ?

Panda or not panda ?

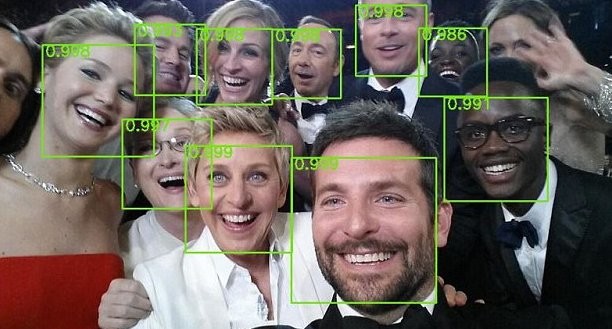

Ian Goodfellow, inventeur des réseaux accusatoires génératifs (GAN), a montré que les réseaux de neurones peuvent être délibérément dupés. En manipulant mathématiquement une image d'une manière indétectable à l'œil humain ! Ainsi les réseaux de neurones se trompent dans la classification des images. L'exemple ci-dessous montre un panda est reconnu après "traitement" comme un singe.

C'est pourquoi, les dangers de ces attaques aux systèmes d'IA sont alarmants. D'autant plus, que les images contradictoires et les images originales semblent identiques pour nous. Les voitures sans conducteur pourraient être détournées avec une signalisation en apparence anodine. Des systèmes sécurisés pourraient être compromis par des données qui apparaît initialement normales.

Peut-on surmonter la limite du Deep Learning ?

Comment pouvons-nous surmonter la limite de l'apprentissage en profondeur et procéder vers l'intelligence générale artificielle ? M. Chollet a un début de réponse. Pour lui, le plan d'attaque consiste à utiliser « notre capacité (très forte) humaine à la reconnaissance des formes, via l'apprentissage en profondeur, afin d'augmenter la recherche explicite et systèmes formels », en commençant par le champ des preuves mathématiques.

Que pensent les stars en IA ?

Ainsi, dans le projet DeepMath, François Chollet et ses collègues ont utilisé l'apprentissage en profondeur pour aider le processus de recherche de preuve. Automated Provers Theorem (APTs) est un sous-champ du raisonnement automatisé et de la logique mathématique. La logique mathématique traitant de prouver des "théorèmes mathématiques" par des programmes informatiques. Ainsi, en simulant les intuitions d'un mathématicien sur des lemmes (théorème intermédiaire dans un argument ou une preuve) pourrait être une piste pertinente à l'avenir.

Yann LeCun, (un autre français) inventeur des réseaux de neurones convolutifs (CNNs ou ConvNet) et directeur de la recherche AI chez Facebook, propose « des modèles basés sur l'énergie » comme méthode de surmonter la limite en matière d'apprentissage profond. En règle générale, un réseau neuronal est formé pour produire une seule sortie. Comme une étiquette d'image ou la traduction d'une phrase. Les modèles à base d'énergie donne toute une série de sorties possibles. Ainsi, les résultats pourraient être les nombreuses façons dont une phrase peut se traduire, ou des scores avec coefficient différent pour chaque configuration.

Enfin, Geoffrey Hinton, largement appelé le « père de l'apprentissage profond » veut remplacer les neurones dans les réseaux de neurones par des « capsules ». Il croit ainsi refléter plus fidèlement la structure corticale de l'esprit humain. "L'évolution doit avoir trouvé un moyen efficace d'adapter des fonctionnalités qui sont au début par voie sensorielle" explique-t-il. Il espère que les architectures des réseaux de neurones à base de capsules seront plus résistantes aux attaques accusatoire de M. Goodfellow vues ci-dessus.

Si tu as aimé merci de mettre un like et/ou de partager :)

Ce billet fait suite de mon article

RSI / CyberSecurity Lecturer / Marketing Digital

6yIntéressant de voir que l'IA peut être berné ... et que cela représente un cyberthreat potentiel énorme